Il robots.txt è un file di testo, da inserire nella root di un sito e indica a uno spider (software dei motori di ricerca che gira alla ricaerca di pagine da indicizzare), quali pagine non deve indicizzare. Utile sopratutto per proteggere pagine e cartelle riservate, per proteggere le cartelle con gli script o semplicemente proteggere pagine che non devono finire sui motori di ricerca.

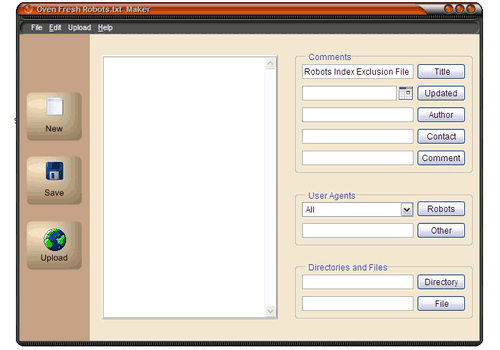

Non è semplice trovare tutti i nomi degli spider e sopratutto dare le direttive giuste; Robots.txt maker permette, grazie a un procedimento wizard di creare il file in modo semplice e veloce.

Non sono necessarie conoscenze particolari, basta segnare quali motori di ricerca (o quali servizi del motore) non devono avere accesso al sito o a parti di esso.